L’invenzione dell’inflazione, le velocità fluttuanti e gli universi a tavolinoCome parziale, parzialissima risposta a tutti i problemi e le anomalie che la teoria evidenziava, i difensori-correttori-revisori del modello standard hanno inventato, a partire dagli anni ottanta con A. Guth e poi con A. Linde, la “teoria dell’Universo a bolle” o “inflazionario” o “gonfiato” (The Inflationary Universe), definito da R. Penrose «una moda che i fisici teorici hanno imposto alla cosmologia». Nella sua versione della teoria inflazionaria, Linde (non senza una certa convergenza con alcune idee dell’ultimo Hoyle) abolisce il “Primo Big Bang” assumendo un Universo eterno che mai avrebbe avuto inizio ma al contempo, visto che evidentemente un solo Big Bang non bastava, moltiplica gli universi e i botti di primo dell’anno postulando infiniti universi “paralleli”, tutti nati da altrettanti Big Bang e sempre autoriproducentesi a “frattale” o a grappolo in altrettante espansioni “locali”, ciascuna diversa dall’altra (per i diversi valori delle costanti fisiche) e nessuna omogenea e uniforme. In ciascuno di questi universi una asimmetria inaugurale connessa a fluttuazioni quantistiche, complice la forza repulsiva ora denominata “quinta forza”, determinerebbe immediatamente dopo il Big Bang una quasi istantanea espansione-lampo iniziale vertiginosamente accelerata fino a superare la velocità della luce (idea, si ricorderà, che fu già di de Sitter), con conseguente enorme dilatazione dell’Universo (di 10⁴³ volte) che, in tale microscopico intervallo (fra 10-³⁶ e 10-³⁴ sec), aumenterebbe addirittura dalle dimensioni di un protone a dimensioni maggiori dell’intero Universo osservabile; poi vi sarebbe una decelerazione che porterebbe alla “normale” espansione del modello standard con un continuo rallentamento. Per più recenti modelli, invece, all’inizio dell’Universo vi sarebbe stata non un’espansione superluminale dello spazio bensì (variando alcune speculazioni di Dirac e Dicke sull’iniziale variabilità della costante G) un’accelerazione della stessa luce a velocità superluminale poi ricondotta al normale parametro c. Ancor più recentemente, poiché il valore della costante di Hubble non quadra bene con l’età presunta del cosmo, si è ipotizzato che il nostro Universo – pur avendo cessato la fase di inflazione – sia ancora piuttosto vicino alle velocità iniziali dell’espansione e stia dunque procedendo a velocità piuttosto alta, seppur sufficiente alla formazione in senso opposto degli agglomerati, ciò per cui la sua età potrebbe tornare ad essere 20 miliardi di anni: come dire che un’automobile, che partita da Milano impiega due ore per andare a Venezia, procedendo più velocemente potrebbe anche impiegare lo stesso tempo partendo da Torino. È infine a rilevarsi che nella maggior parte dei modelli la teoria dell’inflazione presume che l’espansione produca alla fine uno spazio “piatto” o euclideo: poiché infatti la curvatura diminuisce col crescere del raggio allora in una sfera enormemente dilatata lo spazio risulterebbe euclideo alla rilevazione proprio come piatta appare a noi la superficie terrestre, ed inoltre se nell’Universo la densità di massa è piuttosto scarsa (ben al di sotto di un atomo in media per metro cubo, e del resto già nel modello di de Sitter l’Universo era assunto come mediamente quasi vuoto) allora per la stessa teoria della relatività lo spazio sarà euclideo in quanto non “curvato” dalle masse (donde la possibilità di quantificare co me nullo il grado di curvatura nelle equazioni di Einstein così riottenendo le equazioni di Newton o di Poisson).

Il problema di queste teorie, evidentemente, è tarare e calibrare la velocità di espansione dell’Universo in modo da renderla anzitutto compatibile con la formazione degli agglomerati. Al riguardo certo non potevano più bastare le consuete e contraddittorie valutazioni della velocità dell’espansione in base alla quantificazione della “costante di Hubble” in quanto con tale valore si presupponeva un moto recessivo dell’Universo costantemente accelerato, secondo la rigida proporzione meccanica distanza doppia – velocità doppia, che non poteva rendere ragione né delle specifiche varietà né della formazione degli agglomerati. I “correttori” insomma si sono resi conto – non è mai troppo tardi, ed è meglio tardi che mai – che in realtà l’espansione dell’Universo impedirebbe la formazione di atomi, stelle, sistemi planetari, galassie, e allora hanno pensato – mantenendo ferma una certa età stabilita dell’Universo – di accelerare a tutto gas l’espansione quando ancora non si formano le particelle e di decelerarla subito dopo rallentandola sempre più, e in pari tempo differenziandola, al fine di consentire la formazione degli aggregati. L’idea è che alle aporie della cosmologia standard si possa cercare di ovviare all’interno di un modello evolutivo solo introducendo velocità iniziali superluminali e velocità differenziate successive: da un lato un’espansione iniziale superluminale, posta anzitutto per spiegare l’omogeneità e l’isotropia dell’Universo poco comprensibili in base alla teoria classica del Big Bang, consentirebbe una successiva decelerazione tale da permettere a più basse velocità di espansione la condensazione altrimenti impossibile delle particelle e delle galassie; dall’altro lato una serie di espansioni mai omogenee e non uniformi genererebbe uno spazio più espanso là e meno espanso qua, cosicché le varietà locali dell’espansione potrebbero rendere ragione delle diverse fenomenologie in modo da consentire là la recessione e qua la formazione di atomi e galassie.

Con questi escamotages si è cercato dunque di giustificare, nonostante l’espansione, la formazione degli agglomerati e l’isotropia dell’Universo senonché, come ognun vede, la teoria dell’inflazione appare altamente speculativa ed atta non a “salvare i fenomeni” bensì solo a salvare la teoria standard riscrivendola. Puramente speculativi sono i concetti base di queste teorie: la forza repulsiva, l’espansione inflazionaria superluminale, gli infiniti universi “paralleli”. Circa questi ultimi poi si può dire tutto quello che si vuole. Noi non conosciamo che in minima parte l’Universo e ancor meno possiamo sapere di ipotetici universi “paralleli”: possiamo dire che v’è un Universo, che ve ne sono tre, o mille, o infiniti, possiamo immaginare altri universi in cui la velocità della luce o la gravitazione abbiano valori diversi, o in cui Giulio Cesare non varca il Rubicone e si fa un bel bagno, possiamo immaginare tutto quello che vogliamo, del tutto sicuri che quanto diciamo non sarà mai né verificato né smentito. Ma, anche a prescindere da queste considerazioni generali, notiamo quanto di inverosimile vi sia nei presupposti delle teorie inflazionarie. Infatti i revisori del modello standard, dopo l’inflazione, possono decelerare e rallentare sempre più la loro espansione ma mai abbastanza: come si è visto infatti soltanto una velocità d’espansione minore dei moti propri (cioè veri) delle galassie, come ad esempio una velocità minore di circa 300-500-1000 Km/sec, potrebbe consentire i ravvicinamenti e scontri galattici: mentre invece a grandi distanze la “legge di Hubble” prevede velocità recessive anche enormemente superiori. Né questo basta ancora perché nel tempo, in flagrante contraddizione con la “legge di Hubble”, sono risultate galassie vicine e più giovani con alto redshift e galassie vecchie e lontane con basso redshift, mentre dovrebbe essere il contrario. In particolare S. Perlmutter nel 1999 ha osservato delle galassie che (in base all’esame di supernove in esse contenute) si rivelano molto lontane, e che parimenti sono ritenute molto antiche per il lunghissimo tempo che la loro luce ha impiegato per giungere a noi che le vediamo ora come erano allora: siccome però esse evidenziano uno spostamento verso il rosso molto meno marcato di galassie più vicine allora questo significa che, se il loro redshift va interpretato come un Doppler, esse procedono a velocità più bassa delle galassie più vicine e ciò in contraddizione con la cosiddetta legge di Hubble per cui le galassie più distanti devono procedere sempre più velocemente in quanto sarebbero le più antiche risalenti all’epoca della grande accelerazione iniziale dell’Universo.

Senonché, certo i teorici dell’espansione non si sono lasciati spaventare da questa quisquilia. Essi infatti, dopo aver posto dopo l’inflazione un’espansione decelerata per spiegare gli agglomerati, si sono inventati un’espansione nuovamente e improvvisamente accelerata e hanno detto: se la galassia lontana e antica ha un redshift e una velocità a valori troppo bassi allora ciò vuol dire che in quella lontana epoca l’espansione aveva rallentato dopo la fase inflazionaria; poi però, poiché la massa che dovrebbe frenare e arrestare l’espansione si è nel frattempo sempre più diluita, rarefatta e dilatata con l’allargarsi dello spazio espanso con conseguente allentamento della resistenza gravitazionale, allora l’Universo, la cui espansione era sempre più rallentata da miliardi di anni fin quasi ad arrestarsi, all’improvviso in mancanza di attrito e di freni riprende in ultimo a nuovamente accelerare ed ecco perché le galassie più recenti e più vicine – il cui redshift appare spesso stranamente accentuato rispetto alle rilevazioni passate – procedono con velocità maggiore. Del resto già in Lemaître c’era quella strana espansione che accelera, poi frena come un autobus (fase di coasting) perché incontra la resistenza di masse gravitazionali giusto in tempo per consentire agli elementi e alle stelle di formarsi, e quindi – una volta superata la resistenza gravitazionale – riprende a correre “come prima, più di prima”. Così secondo alcuni ultimi scenari l’Universo rallentato non solo, per la scarsa densità della massa che si è diluita, non avrebbe la forza gravitazionale sufficiente a arrestare l’espansione volgendola in contrazione (secondo la vecchia idea del futuro Big Crunch, a cui veramente nessuno oggi sembra più credere), ma addirittura e al contrario spingerebbe l’Universo non più “frenato” dalla materia dilatata ad accelerare sempre più cosicché infine questa espansione accelerata produrrebbe un Big Rip finale del cosmo, ovvero un taglio definitivo, un Final Cut dei legami atomici con allontanamento irreversibile di tutte le particelle del cosmo (ove è evidente la ripresa della vecchia idea di Eddington sullo scoppio finale, anziché iniziale, del “palloncino gonfiato”).

Senonché, se la “legge di Hubble” dice che le galassie più lontane viaggiano più velocemente di quelle più vicine, e poi si scoprono galassie molto lontane che al contrario in base al redshift letto come Doppler risultano muoversi più lentamente di quelle più vicine, allora siamo qui probabilmente in presenza di un’anomalia (l’ennesima) che inficia la “legge di Hubble”. Si dovrebbe allora dire che, poiché la relazione stabilita da Hubble fra velocità e distanza non è il risultato di alcuna misurazione diretta bensì discende da un postulato teorico che troppe volte appare smentito, in realtà fra distanza e velocità non c’è di per sé il minimo rapporto in quanto il movimento di una galassia può essere veloce o lento del tutto a prescindere dal fatto che questa galassia si trovi a noi vicina o da noi lontana. Ma questo non si può dire e allora subentra la variazione della velocità d’espansione. L’idea della decelerazione finale del moto d’espansione è stata formulata solo per salvare la “legge di Hubble” dalle evidenze osservative che (contrariamente a quella “legge”) rivelano galassie lontanissime a basso redshift e dunque – secondo l’interpretazione Doppler – procedenti con bassa velocità, mentre al contrario l’idea della successiva accelerazione dell’espansione deve solo rendere ragione dei più alti redshift di varie galassie meno lontane e però più veloci: così, siccome per la teoria non sono le galassie ad allontanarsi bensì lo spazio che espandendosi le trasporta, allora si è stati costretti a postulare ora un rallentamento ora un’accelerazione dell’espansione. In realtà nulla verifica l’accelerazione o il rallentamento o comunque la variazione di velocità della pretesa espansione dell’Universo: si sono semplicemente trovate galassie lontane o vicine il cui redshift, unilateralmente interpretato come un Doppler, indicherebbe velocità di allontanamento ora maggiori ora minori di quanto ci si attendeva in base alle previsioni della “legge di Hubble”. Si tratta qui di una nuova e inverosimile complicazione ad hoc atta a salvare con la legge di Hubble anche l’idea dell’espansione: trovando galassie i cui redshift non sono quelli che in base alla presunta distanza dovrebbero essere per la legge di Hubble, allora si rallenta o si accelera d’ufficio l’espansione per non dichiarare falsa quella legge.

Certo si possono sempre inventare argumenta ad hoc, rallentando o accelerando a piacere l’espansione onde salvare al tempo stesso i dati osservativi e la teoria. In questo modo gli astrofisici possono giostrare a piacimento i parametri, variando le velocità in modo da rendere ragione di qualsiasi anomalia e così rendendo infalsificabile la legge di Hubble: senonché alla lunga questo modo di procedere, moltiplicato per mille casi, diventa un gioco troppo facile e financo intellettualmente disonesto. Si trova una galassia con z = 0,3 (con z quantificatore di redshift), mentre per la sua presunta distanza dovrebbe avere in base alla legge di Hubble una velocità maggiore, e allora si dice: la galassia avrebbe dovuto avere in effetti una velocità maggiore, ma qui l’Universo ha rallentato; se ne trova un’altra con z = 1,2 mentre per la presunta distanza il valore dovrebbe essere minore, e allora si dice: effettivamente la galassia avrebbe dovuto avere una velocità minore, ma qui l’espansione ha dato una bella accelerata; se ne trova una terza con z = 1,95 e si dice: quello è Dio stesso che si è messo al volante. In questo modo, noi non avremmo semplicemente un’espansione che accelera superluminalmente e poi decresce costantemente (che naturalmente è già ipotesi ad hoc con testabilissima), bensì avremmo un’espansione che continuamente accelera e rallenta come un ubriaco. Sarebbe come se, rilevando la velocità delle auto in autostrada, dicessi: non è x che va a 200 km/h, y che va a 90 km/h, z che va a 130 km/h, bensì è l’autostrada che nel punto di x va a 200, nel punto di y va a 90 e nel punto di z va a 130 km/h: si torna ancora così al fatto che in realtà la rilevazione della velocità di una stella ci dice la velocità della stella e non la presunta velocità di espansione dello spazio. Cosicché, tralasciando di considerare se sia vero che le galassie più lontane siano sempre le più antiche e le più vicine sempre le più giovani, semplicemente domandiamo se non sia meglio rifiutare l’escamotage dell’espansione e accettare la conclusione che in realtà è erronea la pretesa di Hubble per la quale le galassie più lontane siano anche sempre le più veloci.

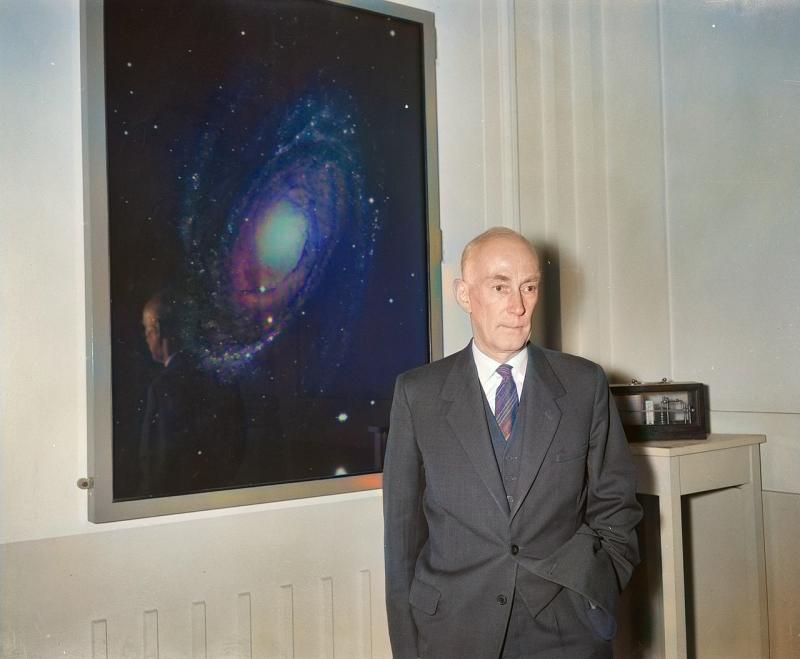

La radiazione di fondo diversamente interpretataUna pretesa prova del Big Bang, come si sa, è l’esistenza della cosiddetta “radiazione cosmica di fondo a microonde” (Cosmic Microwave Background). R. Tolman negli anni trenta disse che la temperatura dell’Universo sarebbe diminuita in presenza di un’espansione, e nel 1948 G. Gamow, R. Alpher e R. Herman pensarono che, come dopo un’esplosione nucleare la zona interessata rimane per decenni contaminata radioattivamente, così nell’Universo attuale doveva pur esservi l’eco della inverosimile temperatura “infinita” dell’istante zero a cui dopo l’esplosione e con la successiva espansione dell’Universo doveva aver fatto seguito un continuo raffreddamento progressivo. Più tardi Alpher e Herman e poi Gamow valutarono che se l’Universo fosse nato con l’esplosione vari miliardi di anni fa allora la sua temperatura attuale dovrebbe essere circa 5 gradi Kelvin. Quindi A. Penzias e R. Wilson, peraltro in tutt’altre faccende affaccendati (dovevano semplicemente rilevare la fonte di certi disturbi nelle comunicazioni), incidentalmente e per puro caso rilevarono nel 1964 una radiazione cosmica di fondo a microonde abbastanza isotropa e ovunque diffusa di quasi 2,7°K (2,7 °K) ovvero –270 °C (0 °K equivale a una temperatura di – 273,15 gradi centigradi: per passare da una scala in gradi centigradi a una scala Kelvin basta aggiungere 273 al valore in gradi centigradi). Immediatamente si interpretò questa radiazione come l’eco e il residuo fossile e dunque quale verifica alla teoria del Big Bang, e Penzias e Wilson furono presto insigniti del Nobel «for their discovery of Cosmic Microwave Background Radiation».

Ancor prima che Penzias e Wilson pubblicassero i loro dati nell’Astrophysical Journal, iniziò la gara per accordare 3°K con la temperatura “infinita” o comunque altissima e con l’antichità dell’Universo. Alla fine il premio Nobel S. Weinberg, nel suo testo su “I primi tre minuti dell’Universo”, ha addirittura ritenuto in tutta serietà di poterci dare la radiocronaca minuto per minuto, a partire dal primo centesimo di secondo, della nascita e della formazione dell’Universo manco egli fosse stata una divinità testimone dell’evento. La chiama familiarmente “ricetta per un Universo caldo”, un Universo in cui dopo il botto la temperatura si dimezza con il raddoppiamento delle dimensioni dell’Universo stesso. Particolarmente importanti risultano i primi tre minuti, piuttosto che una mezz’oretta, ma questo è logico: sappiamo bene che il tre è un numero sacro. Ci si può chiedere ora: come fa Weinberg a sapere cos’è accaduto miliardi di anni fa con tanta precisione, fino a spaccare il secondo? Egli stesso confessò una volta: «devo ammettere che provo un vago senso di irrealtà scrivendo sui primi tre minuti come se veramente sapessimo di cosa stiamo parlando». E, in effetti, noi sorridiamo oggi di J. Lightfoot che nel 1642 proclamò che la creazione era sicuramente avvenuta il 17 settembre del 3928 a.C., e parimenti sorridiamo dell’arcivescovo T. Usher che invece (in base a un diverso conteggio delle generazioni elencate nella Bibbia) disse che la creazione era avvenuta sabato 22 ottobre del 4004 a.C., alle nove del mattino (secondo altri, a mezzodì): perché non dovremmo sorridere di un premio Nobel che addirittura cronometra per la genesi dell’Universo il primo centesimo di secondo?

Qui anzitutto va fatta una prima obiezione: va detto cioè che non era difficile “prevedere” che nell’Universo e negli spazi siderali vi fosse una temperatura media. Praticamente tutti l’avevano “previsto”: per primo Guillaume, che nel 1896 valutò in 5,6°K la temperatura dell’Universo, naturalmente limitatamente allo spazio interstellare della Via Lattea che allora si riteneva coincidente con l’Universo. Poi venne Eddington che nel 1926 in base ai suoi calcoli stimò la quantità di luce proveniente dalle stelle come equivalente a 3,18 °K se tradotta in equilibrio termico, ancora scrivendo l’anno seguente che «al di là di una certa distanza dal Sole la temperatura di un solido o di un liquido scende a –270°C, cioè a 2,7°K sopra lo zero assoluto». Quindi nel 1933 E. Regener, analizzando l’energia dei raggi cosmici, valutò la temperatura media dello spazio – questa volta intergalattico – in 2,8°K. Inoltre con la radioastronomia fin dal 1931 l’inascoltato K. Jansky aveva rilevato il fondo di emissione di onde radio che ora si sa provenire dalla Via Lattea, mentre in seguito si rilevarono (dapprima sempre all’interno della Via Lattea) le radiosorgenti di origine stellare. Parimenti si conosceva la temperatura del Sole e di molte stelle e si aveva un’idea, via via sempre più precisa, delle temperature dei pianeti del sistema solare e dei loro satelliti: ad esempio fin dal 1870 si sa che la temperatura della faccia della Luna non illuminata dal Sole è circa 270 °K ovvero poco sotto 0 °C; parimenti si sa che la temperatura media della Terra è circa 287°K = 14°C; che l’emisfero di Mercurio non esposto al Sole è 92,7°K = –180°C; che l’atmosfera di Giove è –195°; di Saturno –190°; di Nettuno e Urano –200°, di Plutone –236°.

Dunque – sapendo che lassù fa freddino, sottraendo le temperature nei dintorni stellari, riguardando il vecchio Eddington – non era forse così difficile “prevedere” la temperatura media degli spazi siderali intorno a 2,7°K: se 0°K è un punto fuori della scala a cui corrisponderebbe un corpo immaginario privo di calore, se la temperatura si abbassa con il decrescere dell’energia cinetica e se la temperatura assoluta è 0 °K corrispondente ad una condizione estrema in cui gli atomi, quasi privi di energia cinetica, sono praticamente fermi e non esistono temperature ad essa inferiori, allora poteva ben essere ipotizzabile che negli spazi siderali la temperatura dovesse essere solo di poco superiore a 0°K. Così nel 1937 – dunque ben prima di Alpher e Herman, e un po’ dopo Eddington – W. Nernst aveva presupposto un etere ovunque diffuso che, così come assorbiva la luce causandone il rallentamento di frequenza e il redshift, così assorbiva anche la radiazione cosmica causando un riscaldamento del mezzo interstellare valutato prima in 0,75°K e poi in 2,8°K. Quindi nel 1940 una vasta nube interstellare rivelò una temperatura di 2,2,7°K e nel 1941 un astrofisico australiano, A. McKellar, stimò la temperatura dello spazio interstellare in 2,4 °K, valore poi confermato da G. Herzberg: ove il fatto più interessante è che McKellar (come Nernst) fece questa previsione non in base alla teoria del Big Bang con la sua espansione e la sua eco di fondo, bensì studiando le righe nere di assorbimento interstellare rivelate alla spettroscopia; del resto negli anni cinquanta alcuni radioastronomi in Francia e in Russia notarono l’esistenza di un rumore di fondo.

Dunque era sufficiente un’attenta analisi spettroscopica a rivelare la radiazione di fondo, a prescindere dal Big Bang: gli scienziati suddetti non stavano affatto cercando l’eco del Big Bang (a cui Eddington per primo, come sappiamo, non credeva affatto) bensì stavano ipotizzando la temperatura di un supposto mezzo interstellare o ancor più semplicemente stavano misurando il grado di assorbimento interstellare della luce proveniente dalle stelle (d’altronde lo stesso Wilson, nel ’64, era un sostenitore del modello stazionario e non pensava al Big Bang). Poi venne R. Dicke che, nel 1946, scoprì addirittura una radiazione cosmica di fondo con una temperatura inferiore a 20°K (il limite inferiore del suo dispositivo). Per Dicke l’Universo passava attraverso cicli successivi di espansione e contrazione, pur senza un vero e proprio Big Bang iniziale, e tuttavia egli non pensava affatto di misurare una radiazione fossile: «non pensavamo alla radiazione del Big Bang – fu il suo eloquente successivo commento – ma solo a un possibile bagliore emesso dalle più distanti galassie dell’Universo». Più tardi Dicke stimò addirittura in 45°K la temperatura dell’Universo, mentre nel 1951 Alpher ed Herman (fautori invece dell’evento inaugurale) proposero 28°K. Quindi Finlay-Freundlich, che interpretava il redshift in termini di luce stanca, disse nel 1954 che la temperatura T dello spazio intergalattico doveva essere «vicina allo zero assoluto» (near the absolute zero), come pensava anche Hoyle, finendo però per quantificarla come oscillante fra 1,9°K e 6°K. Poi altri ancora esaminarono il grado di assorbimento della luce interstellare e sempre videro che, qualunque fosse stata la stella considerata, il grado di assorbimento della sua luce oscillava fra 2,5 e 3,5°K.

Parlare di “previsione” della radiazione di fondo da parte della teoria del Big Bang è decisamente incongruo perché, a parte le eccezioni del tutto indipendenti da esigenze di riprova del postulato espansionista di cui si è detto, i ricercatori successivi in cerca di prove del Big Bang previdero in realtà valori diversi, e talora molto diversi, da quelli poi effettivamente riscontrati. Come abbiamo visto, vi furono incongrue previsioni di 28°K o financo di 45°K, e solo nel 1948 Alpher e Herman previdero una radiazione base di 5°K a cui si sarebbe dovuto aggiungere «l’energia termica derivante dalla produzione di energia nucleare nelle stelle»: tale valore, senza aggiungervi l’energia stellare, sarebbe dovuto essere «interpretato come temperatura di fondo che risulterebbe solo dall’espansione universale» («interpreted as the background temperature which would result from the universal expansion alone»). Da parte sua Gamow, sostenitore del Big Bang, nel suo libro del 1952 “The Creation of the Universe” previde 7°K, poi nel 1956 previde addirittura 50 °K e infine nel 1961 scese a 5°K. Invece J. Peebles, collaboratore di Dicke e sostenitore del Big Bang, nel 1965 fece una stima di 10°K.

I due ricercatori cominciarono a costruire un’antenna a microonde a Princeton nel 1964 per rilevare effettivamente quanto fosse la radiazione di fondo, ma furono battuti sul tempo da Penzias e Wilson che misero fine alla girandola delle cifre. Come si vede, il problema non era tanto “prevedere” più o meno esattamente (decisamente meno esattamente nel caso dei teorici dell’espansione e del Big Bang) che nell’Universo vi fosse una radiazione e quindi una temperatura, visto che in realtà era piuttosto ovvio che vi fosse: il problema era rintracciare effettivamente tale radiazione e soprattutto dimostrare (ciò che molti non ritenevano affatto) che essa fosse la traccia di un’esplosione originaria. Quando Penzias e Wilson rilevarono i 2,7°K, Gamow e i teorici del Big Bang vi misero subito le mani sopra dicendo che essa era proprio la conferma della loro previsione e la riprova dell’espansione e del Botto: ma in realtà – come abbiamo visto – Guillaume, Eddington, Regener, Nernst, McKellar, Herzberg, FinlayFreundlich previdero l’esistenza di una radiazione di fondo e financo previdero i 2,7°K con ben migliore approssimazione, in vari casi molto prima, e senza vedervi alcuna riprova del Big Bang.

Veniamo ora a un secondo rilievo, con il quale si mostra come dietro tutta questa faccenda della “previsione” dei 2,7°K c’è il trucco. Torniamo a Weinberg: egli non è certamente partito dalla supposta temperatura e dall’età iniziale dell’Universo per ricavarne i 2,7°K attuali, bensì al contrario è risalito a ritroso dai 2,7°K attuali per cercare di stabilire in base a quelli la temperatura al primo secondo dell’Universo e l’età dello stesso. Ovvero: presupponendo l’Universo attuale con i suoi 2,7°K come una sfera, dal diametro di circa trenta miliardi di anni luce, che è andata via via raddoppiando di raggio con l’espansione (per Eddington ad esempio l’Universo in espansione raddoppia di raggio ogni 1300 milioni di anni), Weinberg ha rifatto i conti al contrario nella supposizione che, andando nel passato, la temperatura sarebbe dovuta aumentare in maniera inversamente proporzionale al raggio del cosmo. Così, riducendo questa sfera alla metà del suo raggio attuale come secondo lui doveva essere un tempo stabilito, ha detto: 1300 milioni di anni fa l’Universo era metà di quello attuale e quindi aveva un diametro di quindici miliardi di anni luce, una densità otto volte maggiore (in quanto aumenta come 1/R3, ovvero come l’inverso del cubo del raggio dell’Universo) e una temperatura doppia cioè 6°K; parimenti quando l’Universo era dieci volte più piccolo, la temperatura di fondo era dieci volte più grande dell’attuale e cioè non 2,728°K bensì 27,28°K; quando era mille volte più piccolo, la temperatura era mille volte maggiore e dunque 2728°K. In tal modo, andando sempre più a ritroso nel tempo, quanto più Weinberg dimezzava l’Universo dimezzandone il raggio (si vuole ad esempio che il diametro dell’Universo nei suoi primi 760.000 anni di vita sarebbe stato di 18 milioni di anni luce) tanto più ne raddoppiava la temperatura: così quando l’Universo sarebbe stato 400 milioni di volte più piccolo, allora la temperatura sarebbe stata circa un miliardo di gradi Kelvin, e a un secondo dall’esplosione sarebbe stata 10 miliardi °K.

E ancora, dimezzando-raddoppiando e dimezzando-raddoppiando, e cioè dimezzando sempre più o ad infinitum quel secondo e parallelamente raddoppiando sempre più o ad infinitum quei 10 miliardi °K, si giunge a un tempo T = 0 con volume nullo e temperatura infinita. In tal modo l’età dell’Universo diventa esattamente quella che si voleva diventasse, compatibile cioè con quanto sappiamo sull’antichità di stelle e galassie: ovvero circa 15 miliardi di anni. A questo punto, Weinberg poteva fare la prova del nove ridiscendendo la scala al contrario e fornendo tutti i valori desiderati: cinque minuti dopo il Big Bang la temperatura era diciamo un miliardo di gradi centigradi, un giorno dopo era 40 milioni, dopo 300.000 anni era poniamo 6000°C, dopo 10 milioni di anni era 300°C, e così via fino a giungere a 2,7°K chiudendo il circolo. Senonché, risorge qui il problema già detto: il dimezzamento delraggio e del tempo dell’Universo con concomitante raddoppio della temperatura fino ad avere da una parte un valore nullo e dall’altra un valore infinito è un semplice ed innocuo gioco matematico, come il calcolare la crescita infinita delle oscillazioni di un ponte, privo però di una corrispondente realtà fisica in quanto è impossibile che tutta la massa condensata e contratta dell’Universo stia in un volume nullo o praticamente nullo.

Ma soprattutto non vi è chi non veda qui che questa spiegazione, ben lungi dall’essere una “prova” del Big Bang, in realtà lo presuppone: la supposta età dell’Universo, la pretesa temperatura al primo secondo, il raddoppio del raggio, tutti i valori iniziali sono stati posti in modo da farli combaciare con i 2,7°K attuali; qualunque fosse stata la temperatura attuale dell’Universo (5°K, 20°K o che altro) sempre si sarebbe fatto il giochino, alzando o abbassando la temperatura del primo secondo, allungando o accorciando l’età dell’Universo, dando questo o quel valore del raggio in un tempo dato, in modo da far combaciare i valori. Che verifica è mai questa? Se ad esempio si fosse trovata una radiazione di 12 °K, dunque piuttosto altina, allora evidentemente si sarebbe ringiovanita l’età dell’Universo di qualche miliardo di anni, e si sarebbe detto che l’Universo ha poniamo sette miliardi di anni; se invece si fosse trovata una radiazione di un millesimo di °K allora si sarebbe detto che l’Universo è vecchio poniamo di trenta miliardi di anni visto che in esso la radiazione è ormai così estenuata. Insomma i conti sarebbero tornati comunque: risorge qui quell’“imperialismo algebrico” che pretende di dedurre a priori il mondo.

Veniamo ora a una terza obiezione, e domandiamo: con quale diritto, trovando nell’Universo una certa temperatura media che relativamente a noi considereremmo molto bassa, ne deduciamo che illo tempore l’Universo doveva avere una temperatura un miliardo o dieci miliardi di volte più elevata? Anche qui si tratta di un ragionamento aprioristico, per cui si dice: la temperatura dell’Universo appare di 2,7°K alla rilevazione, ma essa un tempo era molto più alta. Alla domanda “perché?” si risponde: perché la teoria del Big Bang esige un’altissima temperatura iniziale; perché la teoria dell’espansione esige una temperatura in costante e continua diminuzione. Noi non applicheremmo facilmente altrove lo stesso ragionamento: se la nostra temperatura corporea è 37° noi non ne ricaveremmo che dunque il mese scorso era 74° e che quindi 20 anni or sono era putacaso 10.000°, così come sarebbe un po’ difficile vedere in un filo d’erba bruciacchiato la prova di un Grande Incendio passato. In breve, l’interpretazione della radiazione di fondo come un residuo del passato presuppone circolarmente quella teoria che vorrebbe dimostrare. Certamente la temperatura media dell’Universo, considerandone la parte osservabile, diminuirebbe in presenza di un’espansione che ne dilati ed estenda la densità di massa: ma dire questo presuppone e non dimostra l’espansione.

In realtà, cadendo (come per noi cade) la teoria dell’espansione, viene naturalmente meno ogni motivo di postulare una diminuzione della temperatura e della radiazione di fondo. Senonché anche qui, evidentemente, opera potentemente il modello della bomba atomica: la radiazione di fondo sarebbe un’eco dell’Esplosione primordiale, proprio come la decennale contaminazione radioattiva ad Hiroshima è il residuo dell’esplosione nucleare del 6 agosto 1945. L’analogia però è fuorviante: mentre infatti l’esplosione nucleare del 6 agosto 1945 ad Hiroshima è certa, l’esplosione del Big Bang è soltanto postulata. Il risalire genealogicamente a ritroso la radiazione credendo così di giungere a una radiazione originaria di ben diversa intensità non è sempre valido. Certo, conosciamo il metodo del Carbonio 14 in geologia: il carbonio 14 radioattivo assorbito dagli esseri viventi si dimezza dopo la loro morte in un tempo dato (5730 anni) fino a disintegrarsi, cosicché la misurazione del 14C residuo presente in un resto fossile di organismo vegetale o animale ne consentirebbe la datazione (parimenti anche il calcolo del tempo di decadimento dei minerali radioattivi presenti nelle rocce ne consente la datazione). Senonché: col metodo del Carbonio 14 abbiamo fra le mani un fossile che sicuramente è il resto di un organismo vivente cosicché non illegittima ne appaia la misurazione della radioattività onde tentarne la datazione (seppur poi tale metodo risenta in realtà di alti margini di incertezza); invece in cosmologia all’osservazione della radiazione di fondo assolutamente niente, se non una preliminare adesione a una determinata teoria cosmologica, ci dice che tale radiazione sia un “fossile” residuo di una condizione originaria assolutamente diversa.

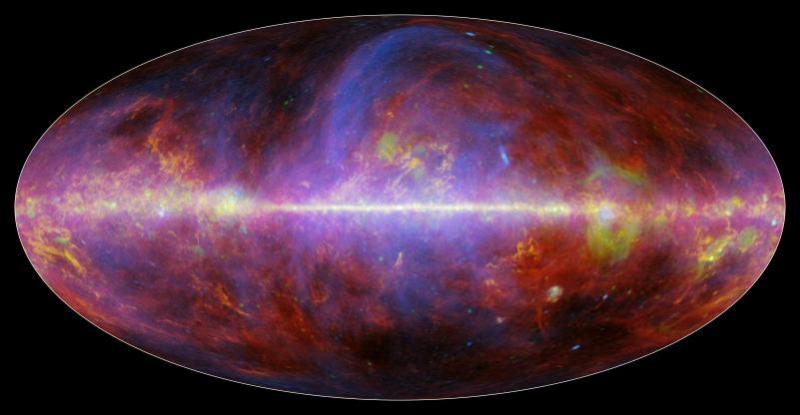

Quarta obiezione: poiché la radiazione di fondo, che si pretende sempre decrescente da circa 15 miliardi di anni, in fondo è stata scoperta quasi mezzo secolo fa, allora diventa lecito obiettare che essa oggi dovrebbe essere di una frazione infinitesimale più bassa di quanto non fosse nel 1964. Certo si può rispondere che tale minima variazione non può essere rilevabile, ma intanto noi non abbiamo alcuna prova che fra 10.000 anni la radiazione – lungi dallo scendere come dice la teoria – non sia ancora 2,7°K, proprio come oggi, senza la minima variazione. Per intanto sappiamo che, ovunque si guardi in avanti nello spazio e all’indietro nel tempo, la radiazione appare sempre 2,7°K. Certo vi sono lievi oscillazioni e variazioni di temperatura, impercettibili fluttuazioni e asimmetrie nella radiazione di fondo, piccole increspature nel mare di radiazione come onde che perturbano leggermente la superficie dell’oceano: infatti alla rilevazione negli anni settanta la radiazione risultò lievemente più intensa – circa una parte su mille – da un lato del cielo che non dal lato opposto (in termine tecnico si parla di “anisotropia di dipolo”); il satellite Cobe (Cosmic Background Explorer) nel 1992 rilevò ancora più lievi e impercettibili variazioni di temperatura – con scarti di uno su centomila, ovvero pochi decimillesimi di Kelvin – quantificate nel numero Q che vale 10 alla -5; e ulteriori recentissime rilevazioni satellitari hanno rilevato fluttuazioni ancora più sottili.

I teorici del Big Bang hanno visto in queste oscillazioni e increspature una nuova prova dell’esplosione primordiale: essi hanno infatti affermato che le increspature sarebbero il riverbero dell’asimmetria caotica inaugurale prodotta dall’esplosione, e in pari tempo sostenuto che esse una volta prodotte dal Big Bang sarebbero state un miliardo di anni dopo la causa delle condensazioni protogalattiche. Nulla da obiettare sul fatto che queste fluttuazioni, che come una sorta di clinamen epicureo consentono gli scontri delle particelle e le condensazioni, possano essere all’origine della formazione delle galassie, purché si intenda che non lo siano state una sola volta e lo siano tuttora. Ma che a loro volta queste fluttuazioni siano state prodotte dal Big Bang, questa è un’estrapolazione inverosimile: non fosse per il motivo che queste oscillazioni sintomo di asimmetria sono molto e troppo lievi, quando invece dovrebbero essere ben più marcate se fossero l’effetto di quella traumatica e mitologica conflagrazione iniziale. In realtà queste fluttuazioni appaiono spiegabili diversamente, senza bisogno di alcun Big Bang. Innanzitutto l’anisotropia di dipolo è dovuta al moto del sistema solare e della Via Lattea attraverso il mare di radiazione, cosicché la radiazione appare lievemente più calda nella direzione del moto e più fredda in quella opposta; ma anche le ancor più minuscole increspature e fluttuazioni rilevate da Cobe e in seguito, lungi dal richiedere un Big Bang esplicativo, sembrano essere il normale ondeggiare della “materia sottile” di cui l’Universo è pregno. Certamente la radiazione di fondo pur apparendo piuttosto omogenea non può essere totalmente omogenea, stante le galassie diffuse nell’Universo, e sembra del tutto naturale che essa appaia lievemente più densa in caso di lieve avvicinamento a un sistema galattico che non altrove: così è probabile che le nebulose e le condensazioni protogalattiche, oltre che esserne determinate, determinino esse stesse le minuscole destrutturazioni asimmetriche nella radiazione di fondo. Nulla comunque verifica che tali fluttuazioni, veramente troppo piccole, siano il riverbero del Big Bang.

Dunque, anziché essere in costante diminuzione, anziché apparire più alta nelle regioni più lontane del tempo e più bassa nelle regioni più vicine, la temperatura media dell’Universo appare invece – entro lievissimi margini di fluttuazioni – uniforme ovunque si guardi, in un equilibrio termodinamico. La radiazione di fondo non rimanda ad alcuna sorgente identificabile: e proprio il fatto che tale radiazione sia sostanzialmente omogenea, uniforme, isotropa, diffusa e continua fa pensare che essa definisca un equilibrio termico generale risultante da sorgenti più o meno uniformemente distribuite nell’Universo e non sia affatto l’eco di un singolo e catastrofico squilibrio iniziale ad altissime temperature. Difficilmente un Universo dinamico in espansione nato da una traumatica esplosione (o anche da un inverosimile allontanamento di tutti i punti senza alcun Big Bang o con mille Big Bang) potrebbe generare un siffatto equilibrio termico. Se la radiazione oggi è sostanzialmente uniforme, perché non pensare che probabilmente lo sia stata nel più lontano passato ed anzi da sempre? Non è necessario cercare una sorgente unica e antica della radiazione nella mitica singolarità iniziale, bensì piuttosto occorre pensare a sorgenti plurime ovunque mediamente diffuse. La radiazione di fondo appare così una costante nello spazio e nel tempo e non una variabile in continua diminuzione: l’Universo potrebbe essere definito come un corpo che, avendo una temperatura costante, ha una radiazione uniforme. Con ogni probabilità, la radiazione di fondo ovunque diffusa non è il riverbero sempre decrescente di un’altissima temperatura iniziale: essa invece definisce semplicemente la normale temperatura media dell’Universo presente, passato e futuro.

Sul paradosso di OlbersHeinrich Wilhelm Matthäus Olbers era un medico, ma questo conta poco. Infatti quando non faceva il medico faceva l’astronomo, e questo viene ricordato nelle storie dell’astronomia. Rinchiuso nel suo osservatorio di Brema il dottor Olbers frugava nella vasta plaga fra Marte e Giove. La legge di Titius-Bode, che intendeva rinvenire una progressione matematica nelle distanze dei pianeti, prevedeva che in quell’area fosse nascosto un pianeta: il pianeta a dire il vero non si trovava, ma il 1 gennaio 1801 G. Piazzi aveva rintracciato in quella plaga Cerere, la cui orbita fu poi meglio definita in base ai calcoli di Gauss. Quindi l’anno seguente, il 28 marzo 1802, Olbers nella stessa area scoprì un altro pianetino che chiamò Pallade. Più tardi ancora, il 1 settembre 1804, venne scoperto Giunone e ben presto l’area fra Marte e Giove risultò sempre più misteriosamente piena di pianetini o asteroidi. Lo stesso Olbers tre anni dopo ne scoprì un altro che denominò Vesta e, molto felice, comunicò la cosa a Bode in una lettera del 3 aprile 1807: «Con la più grande gioia mi affretto a informarvi, mio carissimo amico, di esser stato così fortunato da scoprire, il 29 marzo, un nuovo pianeta della famiglia degli asteroidi». In quella stessa lettera Olbers, volendo spiegare la fascia di asteroidi, fece l’ipotesi che in quel punto il pianeta che avrebbe dovuto esservi secondo la legge di Titius-Bode vi fosse in effetti stato in epoche primordiali, all’origine della formazione del sistema solare, e si fosse poi frantumato – in seguito a una terribile collisione con un asteroide gigante – in migliaia di frammenti vaganti costituenti l’attuale fascia di asteroidi. Questa ipotesi – ampiamente discussa sulla Monatliche Correspondenz – piacque anche agli scrittori e al pubblico, anche se in seguito si rivelò criticabile dal punto di vista scientifico: oggi, in effetti, si preferisce pensare non a un pianeta frantumato ma al contrario a asteroidi risalenti all’epoca della formazione del sistema solare non coagulati in pianeta bensì dispersi a causa della perturbazione gravitazionale di Giove, che sembra non sopportare un pianeta a lui troppo vicino. Invece Olbers, evidentemente, era attratto dall’idea del “pianeta in più”: altri, del resto, cercheranno Vulcano nei dintorni di Mercurio, e ancora oggi v’è chi cerca il decimo pianeta del sistema solare in un punto dello spazio ben oltre Plutone.

Va ricordato inoltre che Olbers fu anche, nella sua epoca, uno dei principali studiosi di comete. Fin dal 1797 al riguardo egli pubblicò a Weimar un lavoro (“Über die leichteste und bequemste Methode, die Bahn eines Kometen aus einige Beobachtungen zu berechnen”). Nel 1812, suggerì correttamente che la coda rettilinea delle comete orientata in direzione opposta a quella del Sole fosse la conseguenza dell’espulsione di materiali durante l’avvicinamento della cometa al Sole: oggi si indica in effetti nel “vento solare” la causa del fenomeno. Nel 1832 infine Olbers mise a soqquadro l’opinione pubblica perché, calcolando la traiettoria di una cometa, ne previde un pericoloso avvicinamento alla Terra: ancora una volta, ma ora in termini più pressanti, si presentava l’idea di collisioni catastrofiche e il direttore dell’Osservatorio di Vienna dovette rassicurare l’opinione pubblica che ancora non era l’ora del Dies irae. Dunque Olbers era veramente un buon ricercatore che, partendo da piccoli corpi celesti come asteroidi e comete, speculava su cosa potesse essere avvenuto illo tempore. Scrive al riguardo C. Böhm: «come facesse quest’uomo, che esercitava coscienziosamente anche la professione di medico, a seguire tante attività contemporaneamente, non è dato sapere. Alcuni riferiscono che gli bastasse dormire solo pochissime ore per notte, cosa che non gli impedì di giungere alla ragguardevole età di 81 anni».

Questo dunque il personaggio di cui parliamo. Ma soprattutto Olbers è oggi noto perché, e con ciò entriamo in medias res, oltre a indagare le comete e a speculare su cosa fosse stata un tempo la fascia di asteroidi fra Marte e Giove, poneva anche domande cui è difficile rispondere (le domande a cui è difficile rispondere sono quelle che amava molto Socrate e che sempre fanno arrabbiare gli “esperti”: Socrate, a quanto pare, fu messo a morte perché faceva troppe domande). La domanda che dunque Olbers pose nel 1826, ma che in realtà fu già di Keplero e di Halley e poi di Cheseaux e di altri ancora, ha la semplicità e l’ingenuità sconcertante delle domande dei bambini: dimmi, perché il cielo è buio di notte? In effetti, quanti di noi ci hanno pensato? Pochi, diciamo la verità. Forse, soltanto qualche idiota nel senso di Dostoevskij o qualche leopardiano pastore errante in Asia possono porsi domande simili. O qualche scienziato di genio: come Einstein che a 16 anni si domandava che effetto farebbe cavalcare un raggio di luce. Perché praticamente chiunque risponderebbe alla domanda di Olbers: il cielo di notte è buio perché è buio, è così e basta, smettila di fare domande. Il cielo è buio così come l’acqua è bagnata e il fuoco è caldo. Hai mai visto un fuoco freddo? Ma il punto è che la domanda, proprio come certe domande apparentemente assurde dei bambini, è tutt’altro che stupida. Certo non si può rispondere dicendo che da noi è notte quando l’emisfero terrestre su cui siamo, nel suo moto di rotazione assiale, volge sdegnoso le spalle al Sole. Olbers infatti vuol sapere perché la luce, che proviene non solo dal Sole ma da tutte le stelle e da tutte le galassie propagandosi in tutte le direzioni, non illumina a giorno e per sempre il cielo e gli spazi tutti. Bisognerà pur rispondergli, e questo tenteremo.

La domanda doveva essere particolarmente ardua per Keplero e per tutti gli Antichi per i quali il cosmo, sia nella prospettiva geocentrica sia in quella eliocentrica, era una sfera cristallina, chiusa, compatta, finita, al di là della quale poteva solo esservi l’Empireo o il Motore Immobile. Il cosmo di Keplero, che aborriva gli spazi infiniti di Giordano Bruno che sgomenteranno Pascal, era una specie di stanza: il Sole al centro, i pianeti intorno, le stelle “fisse” appese alle pareti. Per quanto il mondo di Copernico e di Keplero fosse ben più grande di quello di Tolomeo, era sempre troppo piccolo e non vi era alcuna autentica idea delle immensità spaziali. Copernico in effetti, nel “De revolutionibus orbium coelestium” (I.10), definiva il Sole la “lampada del mondo”: ebbene, perché questa lampada e tutti gli altri luminari appesi al soffitto non illuminano la stanza del cosmo? Perché questa piccola stanza non è illuminata a giorno dalla luce del Sole e delle stelle? Non si illumina forse una stanza con un camino acceso al centro e tante fiaccole accese alle pareti?

Certo, anche da ciò si poteva dedurre che il mondo non è poi così piccolo. Infatti: se fosse così piccolo, chiuso, finito, limitato, allora veramente esso dovrebbe essere illuminato a giorno da quelle migliaia di stelle che si vedono in cielo a occhio nudo, e che col cannocchiale appaiono in numero di gran lunga maggiore come ben sapeva Galileo a partire dal 1609. Dunque evidentemente in realtà l’Universo non è finito ma infinito. Eppure Olbers rifiuta l’idea di un Universo infinito: in uno spazio infinito – dice – vi sarebbero probabilmente o sicuramente non qualche migliaio di stelle bensì infinite stelle e la concentrazione luminosa di infinite stelle dovrebbe veramente illuminare il cielo a giorno. Per questo per Olbers l’Universo è sicuramente molto grande, ma non infinito: altrimenti verrebbe illuminato a giorno. Oggi si dice: la luminosità delle stelle diminuisce con il quadrato della distanza, ma l’effetto è esattamente compensato dal fatto che il numero delle stelle (e dunque la loro luminosità) aumenta col quadrato della distanza, per cui il cielo in un Universo infinito dovrebbe essere illuminato a giorno. Ma noi diciamo: strano ragionamento, quello di Olbers e successori. Se un tale accendesse diecimila candeline di notte nella pianura padana, e poi domandasse perché la pianura padana non ne viene illuminata a giorno, certo la sua domanda verrebbe considerata molto strana. Eppure, proprio questo è il ragionamento di Olbers. Egli ragiona come chi chiedesse perché una candela accesa a Marsiglia non si vede a Parigi.

Un adulto giudizievole potrebbe rispondere a Olbers che fa domande impertinenti: guarda, un Universo chiuso avrebbe maggiori possibilità di essere illuminato a giorno che non un Universo infinito. Mille candele possono illuminare il salone di casa ma non il deserto del Gobi. Uno spazio infinito sarebbe “ancora più infinito” delle infinite stelle che pur potrebbe contenere, proprio come la serie dei numeri interi è in certo senso “ancora più infinita” della serie dei numeri pari che contiene, e proprio questa immensità impedirebbe l’illuminazione a giorno dell’Universo. D’altronde, cos’altro per Newton impediva (beninteso, fino al Dies irae) che le stelle precipitassero gravitazionalmente le une sulle altre se non l’immensa distanza che le separa? Questa immensa distanza come rallenta l’opera della gravitazione così indebolisce la luce: e chi garantisce che il numero delle stelle dovrebbe aumentare col quadrato della distanza guarda caso proprio in modo da compensare esattamente e miracolosamente l’affievolirsi della luce col quadrato della distanza? E poi: infinite stelle non potrebbero comunque illuminare l’Universo a giorno per il semplice fatto che se in qualunque direzione rettilinea si guardi vi saranno infinite stelle, per così dire l’una dietro l’altra, allora esse si copriranno e si occulteranno fra loro in una specie di eclissi stellare. Dunque ponendo un Universo infinito, non ne viene affatto che allora esso sarebbe inondato dalla luce di infinite stelle e così illuminato a giorno. Non fosse che per un altro semplicissimo motivo: la luce viaggia a velocità finita e dunque la luce proveniente da stelle infinitamente lontane non ci ha ancora raggiunto e non ci raggiungerà mai cosicché noi, pur vivendo in un Universo infinito, di fatto siamo raggiunti solo da una quantità finita di luce emessa da un numero finito per quanto alto di stelle. Senza considerare il fatto che le stelle non sono eterne, si spengono anche, smettono a un certo punto di erogare la luce che così non può raggiungerci.

Invero che un Universo chiuso, finito e sferico, per quanto grande, debba essere illuminato a giorno, lo dice anche il premio Nobel Steven Weinberg. Egli infatti, ottimo fisico delle particelle ma anche autore di un infausto libro su I primi tre minuti che ha dato la vulgata della teoria del Big-Bang, trae in questo libro una conclusione logica da un assunto discutibile: se l’Universo un giorno si contrarrà in un Universo più chiuso tendente come Lessie a tornare a casa, al mitico punto iniziale, allora – egli dice – «i nostri posteri [...] troveranno il cielo intollerabilmente luminoso». Insomma: quando l’espansione sarà diventata contrazione, quando lo spazio sarà più ristretto e le stelle si saranno riavvicinate, allora sai che calore! E soprattutto: sai che luce! Lo spazio, ristrettosi, sarà tutto illuminato a giorno. Così, a Olbers che forse preferirebbe vedere il cielo e gli spazi tutti sempre illuminati a giorno e domanda perché non lo siano, Weinberg come un professionista indaffarato risponde: ripassi domani. Si vuole comunque che la teoria del Big Bang abbia risposto al paradosso di Olbers: infatti – si dice – un Universo espanso, in cui le galassie si diradano fuggendo lontano nello spazio così risplendendo sempre meno, spiegherebbe perché il cielo non è illuminato a giorno. Ma – si potrebbe obiettare – un Universo in espansione a forma di sfera dovrebbe al contrario essere illuminato dai raggi di luce che attraverserebbero geodeticamente la sfera così tornando indietro, ciò che non è. Certo basterebbe supporre che lo spazio si espanda a una velocità superiore a quella della luce, per impedire che la luce delle galassie lontane giunga a noi, ma questa è una risposta convincente? Va così veloce l’Universo? Se sì, bisognerebbe allora multarlo per eccesso di velocità. Insomma: come si vede, anche teorie che van per la maggiore non rispondono adeguatamente al paradosso di Olbers. In realtà né un Universo finito né un Universo in espansione, bensì solo l’ammissione di un Universo infinito sembra costituire una prima risposta al paradosso.

Certo si potrebbe rispondere a Olbers che la sua domanda rivela una mentalità un po’ ristretta. Infatti proprio come un provincialotto Olbers sembra chiedere perché il suo villaggio di periferia non sia illuminato di notte come il centro di New York. Di più: egli sembra credere che, poiché è buio l’angolo in cui vive, allora ovunque sia buio. Ma (senza ripassare domani come suggerisce Weinberg) se noi fossimo al centro della galassia, al centro della Via Lattea, dove la densità dei sistemi stellari è molto più alta, allora probabilmente vedremmo il cielo molto più fortemente punteggiato di luci e molto più luminoso, anche di notte. Parimenti, se noi fossimo in uno dei tantissimi sistemi stellari binari che popolano le galassie, allora due soli insieme, magari dandosi il cambio di giorno e di notte, farebbero una bella luce. Olbers potrebbe leggere il racconto di Asimov, “Cade la notte” (vero è che è del 1941): ove si racconta del pianeta Saro in cui gli uomini si godono la luce di ben sei soli. Questo farebbe contento Olbers? C’è qui abbastanza luce? Perché qui, infine, si ha il sospetto che il caso sia da psicoanalisi: sembrerebbe che Olbers non riesca a sopportare quel buio degli spazi siderali che già inquietava Pascal. Come i bambini, ha forse paura del buio: ha paura dell’Orco che lo porta via, e vuole il lumino sempre acceso. Verrebbe da dire, a Olbers che ripete in veste scientifica le domande dei bambini: sono umane, molto umane, le radici psichiche dei problemi scientifici! E però, noi non siamo in un sistema stellare doppio né triplo né sestuplo e nemmeno siamo al centro della galassia: siamo invece in un angolino un po’ periferico e buio. Certo, se Olbers vivesse nei dintorni del Sole nemmeno si sarebbe posto il suo dilemma. D’altra parte è anche vero che se per assurdo vivesse sul pianeta Venere allora troverebbe ancora più buio che non sulla Terra, visto che i raggi solari difficilmente riescono a penetrare la spessa coltre atmosferica che ricopre il pianeta. Insomma, Olbers non vuole capire che gli è andata abbastanza bene, stando sulla Terra.

Tuttavia non è il caso di psicoanalizzare Olbers, ed è preferibile prendere sul serio la sua domanda sul piano scientifico. Certo la questione sembra un po’ complessa: forse sarebbe meglio non fare tante storie, e dire che in realtà il cielo è buio di notte perché di notte Dio spegne la luce. Ma Olbers non si accontenterebbe di questa risposta e insisterebbe. Del resto egli ha sempre cercato di far valere la forza probante del suo paradosso, e nei suoi scritti dice come prevenendo ogni obiezione: anche dalle stelle più lontane, la luce deve giungere a noi. Perché ciò non succede? Come può un raggio di luce estinguersi? E qui che dire? Certo se si getta un sasso nell’acqua a Genova nessuno chiederebbe perché le onde che si propagano non arrivano fino in Africa: invece Olbers chiede perché le onde luminose emesse da stelle enormemente lontane non si propaghino all’infinito, giungendo a noi intatte.

Al riguardo possiamo rispondere notando tutti i casi in cui la luce viene non solo indebolita e rallentata di frequenza, ma proprio oscurata e annullata dal mezzo in cui passa. Così un gas ionizzato assorbe e disperde fortemente la luce. Gli atomi e le particelle assorbono i fotoni tramutandoli in massa ed energia. Così lo scontro fra fotoni e particelle, come verifica la fisica delle particelle, produce opacità: in particolare (effetto fotoelettrico) la radiazione luminosa incidente, investendo un corpo e percuotendone gli atomi, può (se la frequenza è superiore a una data soglia) strapparne via gli elettroni cedendo loro l’energia con cui essi si svincolano e si liberano (ionizzazione), e parimenti (effetto Compton) un fotone urtando un elettrone libero ne viene deviato e sempre, mentre ne aumenta la lunghezza d’onda, perde energia cedendola all’elettrone: in entrambi i casi il fotone perde energia e, nell’effetto fotoelettrico, in quanto tale scompare. Poiché gli elettroni sono, fra le particelle conosciute, le più diffuse nell’Universo, ben si comprende l’alto coefficiente di assorbimento di fotoni nell’Universo con conseguente produzione di cielo buio. Ancora, nella collisione (scattering) fra due fotoni si ipotizza la generazione di una coppia elettrone-positrone e nuovamente i fotoni in quanto tali scompaiono. In termini più classici si deve rilevare invece che per le “frange di interferenza” le onde luminose – passando attraverso una doppia fenditura posta in un ostacolo – interferendo e sovrapponendosi fra loro possono rinforzarsi producendo più luce (quando le loro creste “in fase” si sovrappongono e si sommano) ma anche annullarsi reciprocamente producendo opacità (quando le creste corrispondono “fuori fase” agli avvallamenti). Così, ogni qual volta la luce trova un ostacolo nel percorso interstellare (materia nebulare etc.), essa troverà in genere dei varchi, delle fenditure multiple attraverso cui passare, in tal modo producendo i fenomeni di interferenza il cui esito può essere l’annullamento della luce. Dunque, come le interferenze fra le onde acustiche producono un rumore di fondo con perdita di informazione, parimenti le interferenze fra onde luminose possono produrre perdita di visibilità: in questi casi, è proprio l’eccesso di luce a generare il buio; sovrapponendosi alla luce, la luce può produrre oscurità. In questo modo la luce è dispersa, assorbita. Continuamente nell’Universo le onde luminose non solo rallentano la frequenza ma perdono la loro energia cedendola alle particelle urtate.

Ma Olbers a questo certo avrebbe qualcosa da obiettare, come si legge in un articolo da lui scritto dal titolo “Sulla trasparenza dello spazio cosmico” (Über die Durchsigtigkeit des Weltraumes) e pubblicato nel 1823 nell’Annuario astronomico di Berlino. In questo articolo egli dice infatti che l’assorbimento della luce interstellare c’è, ma è molto minore di quanto ritenesse Jean Philippe de Cheseaux e dunque non è quello il problema. In effetti il valore dell’assorbimento interstellare proposto da Olbers è assai vicino a quello oggi adottato. E ancora si potrebbe aggiungere: la luce è senz’altro in parte assorbita dalla materia interstellare ma in molti casi essa non può essere completamente assorbita per il semplice fatto che la luce riscalda con la conseguenza che dunque il mezzo interstellare, assorbendo la luce, dovrebbe riscaldarsi e quindi illuminarsi così rendendosi visibile. Senonché si potrebbe qui rispondere ad Olbers con la radiazione di un corpo nero: l’Universo con i suoi bui spazi siderali appare come una specie di “corpo nero” che assorbe l’energia luminosa sparsa in ogni direzione da stelle e galassie così in effetti riscaldandosi pur senza giungere alla visibilità nell’ottico. Se si obietta dove sia l’energia e il calore emessi dall’Universo sotto forma di radiazione, allora si può oggi rispondere: è la famosa “radiazione di fondo” di circa 3 gradi Kelvin, ignota a Olbers perché scoperta da Wilson e Penzias nel 1965 e troppo frettolosamente catalogata come eco del cosiddetto Big-Bang. Si dirà: non è un gran riscaldamento questo 3°K che corrisponde poi a – 273 gradi Celsius. Ebbene sì: nell’Universo fa un po’ freddino. Ma pensiamo a quanto più freddo farebbe se non ci fosse l’assorbimento della luce stellare e il conseguente riscaldamento del mezzo intergalattico. Che cos’è la luce se non calore, energia? Dunque, il fatto che l’Universo sia buio ci dice soltanto che in esso c’è poco calore, poca energia.

La formazione degli elementi senza il Big BangUno dei problemi che si pongono, per una cosmologia che voglia essere alternativa al Big Bang, è quello di spiegare la formazione degli elementi. I teorici del Big Bang dicono che, nelle fasi immediatamente successive alla misteriosa esplosione, la temperatura permane altissima (enormemente più elevata della temperatura del nucleo solare) e che questa altissima temperatura spiegherebbe la formazione – altrimenti dichiarata incomprensibile – delle particelle e successivamente degli elementi sia semplici che pesanti. Così a un secondo dal Big Bang, quando la temperatura sarebbe stata 10 miliardi °K, si sarebbero formati protoni, neutroni, elettroni, fotoni, neutrini; ed entro i primi tre minuti dopo l’esplosione, quando la temperatura sarebbe stata 1 miliardo di °K, si sarebbero formati i primi nuclei atomici. Ma è lecito dubitare della verità di tale asserzione. Già Eddington, ai critici che gli obiettavano che solo ad una temperatura enormemente superiore a quella da lui stimata si sarebbero avute le reazioni nucleari all’interno delle stelle, rispose dicendo loro di andare a cercarsi un posto più caldo nell’universo: quel posto più caldo i cosmologi hanno ritenuto di trovarlo nell’inferno del Big Bang, senonché è lecito dubitare che ve ne fosse davvero bisogno per spiegare la formazione degli elementi sia leggeri che pesanti. Pretendere infatti che sia necessaria una temperatura di dieci miliardi di gradi Kelvin per formare i protoni, i neutroni, gli elettroni, i fotoni, i neutrini e che occorra una temperatura di un miliardo di gradi Kelvin affinché i protoni e i neutroni possano unirsi per formare nuclei atomici, è incongruo: di fatto fotoni e neutrini vengono continuamente prodotti dal Sole che certo (temperatura del nucleo = 13 milioni di °K; di superficie = 6000 °K) è ben lontano da quelle temperature, e nemmeno esse vengono raggiunte negli acceleratori ove si producono e si annichilano artificialmente le particelle.

Con il Big Bang inoltre si vuole spiegare non solo la formazione delle particelle bensì anche la formazione degli elementi semplici dell’universo, quali l’idrogeno e l’elio nonché l’idrogeno pesante (deuterio) e il litio. Soprattutto, si pensa al riguardo che un problema particolarmente difficile sia costituito dall’elio. Si è rilevato infatti che nell’universo e in particolare nelle nebulose sparse esiste non solo molto idrogeno (oltre a percentuali di carbonio, azoto, ossigeno, metano etc.), ma anche (per circa un terzo) molto elio: ora, poiché l’elio è un elemento molto particolare che si forma all’interno delle stelle alla temperatura di dieci milioni di gradi e poiché esso appare in nebulose e luoghi diffusi dell’universo ove non esistono stelle né temperature così alte (essendo in genere la temperatura di una nube interstellare solo di pochi gradi sopra lo zero assoluto), ci si chiede da dove provenga tutto questo elio e si risponde che quelle altissime temperature atte a formare questo particolare elemento, se non sono quelle delle stelle, sono evidentemente quelle del Big Bang. Se infatti non vi fosse mai stato alcun Big Bang e l’universo fosse eterno allora, se dall’eternità l’idrogeno confluisce nelle stelle ove si trasforma in elio e dunque in luce, si domanda perché l’idrogeno non sia tutto trasformato in elio e quindi da dove provenga l’abbondanza di idrogeno ovunque riscontrabile nell’universo in quantità ben maggiore dell’elio, in tal modo traendone argomento per addebitarne la grande produzione direttamente e in toto all’esplosione primordiale.

Al riguardo è stato piuttosto facile approntare i calcoli ad hoc e, inserendo certi dati sull’età dell’universo e la sua densità nei primi presunti istanti, ricavarne tautologicamente proprio quella quantità di elementi leggeri che corrisponde al valore attualmente rilevabile. Senonché, non è necessario spiegare con l’enorme calore del Big Bang la formazione degli elementi semplici dell’universo. Invero, per quanto riguarda l’idrogeno, non sembrano sussistere particolari problemi tali da chiamare in causa il Big Bang: l’atomo di idrogeno è infatti il più semplice, essendo costituito dall’incontro fra un protone e un elettrone con successiva orbitazione di quest’ultimo, e i protoni e i neutroni abbondano nell’universo. L’associazione dei nuclei e degli elettroni in atomi come l’atomo di idrogeno può avvenire con 1000 °K ma anche decisamente meno: la temperatura delle nubi molecolari ove l’idrogeno è di casa è circa 10 °K. Anche per quanto riguarda gli isotopi dell’idrogeno, quali il deuterio, si tratta infine di atomi di idrogeno nel cui nucleo si è associato un neutrone che è pur esso (assieme ai protoni e agli elettroni) una particella molto diffusa nell’universo. Anche la formazione di una semplice molecola stabile di idrogeno (H2) avviene piuttosto facilmente, almeno là ove vi sia una certa densità di atomi di idrogeno (superiore alla densità minima che è un atomo per centimetro cubo); parimenti l’ossigeno (sia pur ben più raramente) si forma anch’esso negli spazi in quanto l’atomo di questo gas richiede per la sua formazione l’associazione di otto protoni, otto neutroni e otto elettroni.

La formazione dell’elio (He) è invece più complessa, ma non costituisce un problema irrisolvibile al di fuori del quadro del Big Bang. Il nucleo dell’atomo di elio è composto di particelle a e precisamente di due protoni e, per gli isotopi elio-3 e elio-4, rispettivamente uno o due neutroni: ora, è vero che è assai difficile che (nella forma più complessa di elio) queste quattro particelle – due protoni e due neutroni – si riuniscano a dieci milioni di gradi con esatta proporzione per formare in una stella di piccola massa un nucleo di elio, così come è difficile che il nucleo di elio unendosi con due elettroni formi l’atomo di elio (due protoni, due neutroni, due elettroni), ma è anche vero che, essendo i protoni e i neutroni (come gli elettroni) le particelle più diffuse nell’universo, allora, con l’aiuto di altre particelle agenti come catalizzatori chimici (che nelle stelle di massa maggiore è il carbonio), è comprensibile che infine protoni e neutroni in certe proporzioni e condizioni date generino il nucleo dell’elio e questo di fatto avviene nelle stelle. Così due nuclei di deuterio (costituiti ciascuno da un protone e un neutrone) urtandosi alla temperatura di dieci milioni di gradi anziché rimbalzare si fondono (è il processo della fusione nucleare solare) in uno di elio (due protoni, due neutroni).

Questo però non significa che si richieda sempre una temperatura di dieci milioni di gradi, data dal supposto post-Big Bang, per formare l’elio: infatti l’elio non si forma soltanto nelle stelle compiute bensì anzitutto in quei luoghi delle nebulose protosolari in cui, in uno spazio ampio quanto un intero sistema solare, si sono già attivati i processi destinati a generare le stelle in quanto la contrazione gravitazionale ha acceso le prime reazioni termonucleari con conseguente produzione di elio. Così l’elio si trova sui pianeti gassosi come Giove e Saturno, ove certamente le temperature non sono alte quanto quelle interne al Sole, e sulla Terra (ove peraltro è praticamente assente) può essere formato quando, certamente non a milioni di gradi, si accende un pezzo di legna nel camino e il carbonio si mescola con l’ossigeno. Peraltro l’elio che si trova nelle nebulose oltre che nelle stelle può anche essere il residuo rilasciato da precedenti formazioni stellari in quanto esso una volta formatosi viene espulso nell’universo dalle stelle morenti (come nelle esplosioni di supernova). Dunque per la formazione dell’elio nelle nebulose si richiede certamente un’alta temperatura, che però può formarsi senza la necessità di postulare nessun Big Bang a monte.

Il presupposto più semplice è dunque che da sempre esistano le nubi di polveri e gas che ovunque vediamo nell’universo, principalmente contenenti l’idrogeno che vi si forma e l’elio che vi si conserva una volta formatosi nelle stelle precedenti: è più semplice pensare che l’idrogeno, l’elio e gli altri elementi semplici si formino nelle nebulose primordiali, e anche nelle stelle precedenti, che non ritenerli l’effetto poco comprensibile della singolarità esplosa. Infatti se l’elio una volta espulso e diffuso nell’universo può sopravvivere per molti milioni di anni (così come sopravvivono i raggi gamma e gli atomi di carbonio espulsi dalle supernove che formeranno altre stelle), diventa invece difficile pensare che esso possa sopravvivere fino ad oggi per 13 o 15 miliardi di anni dopo il Big Bang in quanto in un periodo siffatto esso si sarebbe probabilmente da tempo diluito e sciolto nell’universo nei suoi protoni e nei suoi neutroni di partenza attraverso i processi di decadimento a, cosicché anziché dire che l’elio sia stato prodotto dal Big Bang occorrerebbe domandarcisi come esso sia potuto sopravvivere per così tanto tempo al Big Bang: anziché un elio residuo di un Big Bang avvenuto 15 miliardi di anni fa è più concepibile un elio in una nebulosa quale residuo di stelle precedentemente attive, oltre che formatosi ex-novo nelle nebulose in procinto di generare stelle alle opportune temperature.

Il fatto poi che non tutto l’idrogeno sia diventato elio (come si vorrebbe fosse in un universo eterno) si spiega proprio con le particolari condizioni in cui si genera l’elio: l’atomo di elio non si forma comunque e ovunque, ma si forma solo alla opportuna temperatura stellare data la fusione di due atomi di idrogeno o solo dato il legame fra due e solo due protoni e due e solo due neutroni; soltanto una minima parte (meno del 5%) dell’idrogeno e del gas presente nelle nubi interstellari si trasforma in stelle, e comunque esso si riscioglie in gas sparso con la morte delle stelle. Il paradosso dell’eternità – nel quadro di un eterno ciclo di nascita e morte degli elementi e delle stelle – non deve colpire più di quanto colpisca la singolarità iniziale, incomprensibilmente concepita come eterna o creata dal nulla, cosicché eterno per eterno è preferibile il più semplice in modo da non introdurre con l’incredibile singolarità iniziale un elemento del tutto arbitrario e speculativo: noi sappiamo che le particelle vi sono, cosicché possiamo anche pensarle da sempre e per sempre esistenti in un continuo gioco di generazione e annichilazione e trasformazione reciproca, mentre invece è assai più ipotetico e fantastico supporre a monte una specie di SuperParticella da sempre esistente che poi esplodendo le generi. In realtà la teoria del Big Bang non fa altro che attribuire in un sol colpo ai primi secondi immediatamente susseguenti la presunta esplosione primordiale con le sue altissime temperature la formazione degli elementi semplici che invece si formano in un lungo processo all’interno delle nebulose e nelle formazioni protostellari. Gli astrofisici che vogliono spiegare con il calore del Big Bang – anziché con le combinazioni chimiche dei protoni, dei neutroni e degli elettroni nelle condensazioni sprigionanti calore – la formazione degli atomi del gas dell’idrogeno e dell’elio non si rendono conto della circolarità, perché a sua volta l’alta temperatura del Big Bang richiede di essere spiegata con quelle particelle che dovrebbe spiegare.

Per quanto riguarda invece la formazione degli elementi pesanti, la spiegazione ad opera di R. Alpher e R. Herman (1948) e poi di G. Gamow – celebrata come uno dei più grandi successi della teoria del Big Bang – non convince più. Infatti gli scienziati suddetti, sapendo che la costruzione degli elementi pesanti richiede (ben più di quelli leggeri) condizioni di temperatura e densità estremamente alte, hanno rinvenuto a ritroso nei primi minuti ad altissima temperatura susseguenti al cosiddetto Big Bang, naturalmente accortamente calibrandone la temperatura compatibile per la bisogna, l’atto di battesimo degli elementi pesanti. Allora si è detto: vedete? questa portentosa teoria, oltretutto, spiega anche la formazione degli elementi pesanti. Ma in realtà già a partire dal 1957 (in un fondamentale articolo di Hoyle, W. Fowler e G. e M. Burbidge) si è compreso che gli elementi pesanti dal carbonio in poi si formano esclusivamente nelle stelle, particolarmente nelle reazioni nucleari proprie delle fasi terminali da gigante rossa e supernova (segnatamente nella supernova, quando si esaurisce l’idrogeno e prima che essa esploda, avvengono reazioni per cui tre atomi di elio fondendosi ne producono uno di carbonio e poi ancora si produce azoto, ossigeno, ferro): anche qui, non sono necessari i miliardi di gradi Kelvin immediatamente seguenti al Big Bang, bensì bastano e avanzano i cento milioni di gradi di un nucleo di supernova (o anche, per quantità infinitesime, i dieci milioni di gradi all’interno di una stella). Nemmeno le esplosioni da raggi gamma vengono più spiegate come residui dell’“Esplosione primordiale”: dunque proprio non serve nessun Big Bang.

Invero si domanda: se dall’eternità l’elio continuamente prodotto nelle stelle viene a sua volta in esse infine trasformato in elementi pesanti, e se poi le stelle dopo aver consumato l’idrogeno e l’elio esplodono scagliando gli elementi pesanti così generati nello spazio, allora perché l’elio non è tutto trasformato in elementi pesanti, e da dove proviene l’abbondanza di elio e la scarsezza di elementi pesanti ovunque riscontrabile nell’universo, visto che l’idrogeno e l’elio costituiscono rispettivamente il 68% e il 28% degli elementi dell’universo? Come si vede questa obiezione è la replica della precedente: prima si domandava perché tutto l’idrogeno non si sia trasformato in elio, ora si domanda perché tutto l’elio non si sia trasformato in elementi pesanti. Ma certo, circa la sorte degli elementi pesanti formati dall’elio nelle stelle terminali, è ipotizzabile che essi, dopo essersi così formati e dopo essere passati attraverso i più traumatici cambi di temperatura, non sussistendo più le altissime temperature stellari che li hanno generati, tornino a frantumarsi e a sciogliersi per molteplici vie negli elementi di partenza – protoni, neutroni, elettroni – così costituendosi a tutti gli effetti un ciclo: ciò che spiegherebbe la continua produzione e abbondanza di idrogeno e elio nell’universo e la concomitante scarsezza di elementi pesanti.

Per quanto riguarda infine – dopo la formazione delle prime particelle, degli elementi semplici e di quelli complessi – la formazione delle nebulose protogalattiche, qui sappiamo con certezza che le dissolventi altissime temperature iniziali sono esiziali e si richiedono invece temperature decisamente più basse (le alte temperature vengono semmai dopo, quando si innesca il processo di fusione nucleare con trasformazione dell’idrogeno in elio che forma le stelle). Per questo nella teoria del Big Bang diventa indispensabile un raffreddamento successivo, che sarebbe avvenuto un miliardo di anni dopo il Botto, onde spiegare la successiva formazione delle stelle e delle galassie: l’inferno del Big Bang impedirebbe la creazione. Ma allora ci si chiede a che cosa serva la teoria del Big Bang: una teoria cosmologica, alla fin fine, dovrebbe spiegare anzitutto – dopo gli elementi – la formazione delle nebulose originarie da cui si dipartono stelle e galassie, e se per spiegare questo si richiedono temperature non così alte allora sembra inutile immaginare a monte di quelle temperature una temperatura altissima che poi si è abbassata, un Grande Incendio che poi si è spento. In questo caso, Dio sarebbe un cuoco maldestro che per preparare un piatto tiepido lo fa prima bruciare scaldandolo fino all’inverosimile e poi lo fa raffreddare: ora, come diceva Einstein, il Signore è sottile ma non malizioso e – aggiungerei – nemmeno stupido.

Qui si tratta proprio di un elementare principio di economia del pensiero: entia multiplicanda non sunt praeter necessitatem, simplex sigillum veri. Non a caso il saggio re Alfonso X di Castiglia, agli astronomi di corte che gli mostravano le nuove complicatissime tavole dei pianeti su base geocentrica (le tavole alfonsine che sostituivano le ormai inservibili tavole toledane), sbottò dicendo: se fossi stato Dio avrei fatto le cose in modo più semplice. Certo sappiamo che il mondo è complesso e che la teoria assolutamente semplice che lo spieghi non v’è: ma ciononostante rimane lecito il sospetto su una teoria quando essa appaia ridondante, sovraccarica e insomma inutilmente complicata. Nella fattispecie: se ciò che necessita per spiegare la formazione degli elementi e delle protonebulose e protogalassie è un piatto non caldissimo, che necessità v’è di supporre prima un piatto bollente poi raffreddato? Perché non assumere direttamente questo “piatto semifreddo” (o insomma non caldissimo) come condizione iniziale senza immaginare alle spalle una inverosimile e assolutamente inutile conflagrazione cosmica?

L’Universo mancante Come si è visto, il tentativo di salvare la teoria dell’espansione dalle anomalie sempre più insorgenti, e in particolare il tentativo di spiegare le condensazioni e le interazioni di particelle e corpi celesti nonostante l’espansione che tutto allontanerebbe, ha portato negli ultimi decenni alla teoria dell’inflazione e poi ad una proliferazione sempre più incontrollata di modelli matematici ad hoc. Uno degli ultimi tentativi volti a salvare la teoria dell’espansione ha chiamato in causa la “materia oscura”. Poiché la difficoltà teorica riguardava soprattutto i superammassi galattici, che veramente non si capisce come possano tenersi gravitazionalmente insieme a distanze non “locali” ma veramente enormi se parimenti agisse una contraria forza repulsiva dovuta all’espansione, allora i teorici del modello standard, appellandosi ai calcoli per i quali solo una massa gravitazionale dieci o cento volte maggiore di quella osservata potrebbe giustificare questi elevatissimi redshift e tenere insieme gli ammassi e i superammassi nonostante l’espansione, hanno inventato un autentico coup de théâtre. Essi infatti avrebbero dovuto dire: poiché la massa gravitazionale effettivamente rilevata nell’Universo con una certa densità media per metro cubo (0,015 atomi per metro cubo) è veramente bassa, poiché l’Universo è in media quasi vuoto, poiché è sottopeso mentre la teoria dell’espansione sta in piedi solo se esso è bello pienotto, poiché in esso la densità media di massa rilevata è dieci o addirittura cento volte minore di quanta ne occorrerebbe per tenere uniti a enormi distanze ammassi e superammassi in presenza di un’espansione dell’Universo, allora evidentemente non esiste nessuna espansione dell’Universo. Invece hanno detto: no, c’è veramente nell’Universo una massa gravitazionale che è dieci o addirittura cento volte maggiore di quella che si rileva. Alla domanda: e dov’è questa “massa mancante”, questa missing mass, se non solo non si vede ma nemmeno si rileva in nessun modo?, la risposta è stata: è una invisible mass, una Dark Matter, una fantomatica e misteriosa Materia Oscura. Così la materia oscura, ipotizzata originariamente negli anni trenta da Zwicky come massa suppletiva atta a spiegare un problema concreto come l’assorbimento interstellare e il conseguente fenomeno della “luce stanca”, nonché le eccessive velocità delle stelle periferiche nelle galassie, è diventata in seguito la stampella principe della teoria dell’espansione e del Big Bang.